chatgpt的算法原理是基于GPT-3。先通过人工标注方式训练出强化学习的冷启动模型与reward反馈模型。最后通过强化学习的方式学习出对话友好型的ChatGPT模型。

InstructGPT是基于GPT-3模型训练出来的。具体步骤如下:

1。从GPT-3的输入语句数据集中采样部分输入。基于这些输入。采用人工标注完成希望得到输出结果与行为。然后利用这些标注数据进行GPT-3有监督的训练。该模型即作为指令式GPT的冷启动模型。

2。在采样的输入语句中。进行前向推理获得多个模型输出结果。通过人工标注进行这些输出结果的排序打标。最终这些标注数据用来训练reward反馈模型。

3。采样新的输入语句。policy策略网络生成输出结果。然后通过reward反馈模型计算反馈。该反馈回过头来作用于policy策略网络。以此反复。这里就是标准的reinforcement learning强化学习的训练框架了。

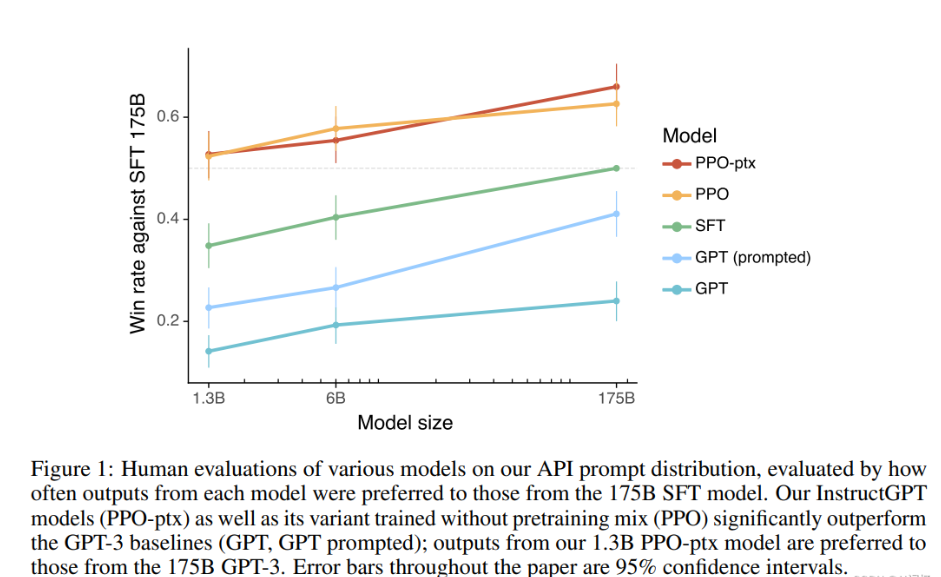

所以总结起来ChatGPT(对话GPT)其实就是InstructGPT(指令式GPT)的同源模型。然后指令式GPT就是基于GPT-3。先通过人工标注方式训练出强化学习的冷启动模型与reward反馈模型。最后通过强化学习的方式学习出对话友好型的ChatGPT模型。如下是论文中相应对话友好型的定量结果(其中PPO-ptx曲线就是InstructGPT模型)。可以看到在回答友好型上InstructGPT是远超原始GPT的:

本文地址:https://gpu.xuandashi.com/70227.html,转载请说明来源于:渲大师

声明:本站部分内容来自网络,如无特殊说明或标注,均为本站原创发布。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。分享目的仅供大家学习与参考,不代表本站立场!